类脑计算与神经网络加速

2016-01-09 21:37

525 查看

今天花了一下午时间看了一期计算机学会通讯的杂志,这期的专题是《类脑计算》,正好与我目前研究的深度学习有很大的关联,看完这期杂志之后得到了不少感悟,在这里稍作总结。当然首先给出这期杂志的地址:《类脑计算》

一、导言

首先,看完杂志之后的一个最大的感触就是“一个人的眼界很重要”。为什么这么说呢,作为一个算法研究人员,我们每天都在看论文,去搜寻别人提出的方法,从本质上讲这就是有一个扩宽眼界的过程。和牛人交流的方式多种多样,最直接有效的当然是面对面,这也是为什么那些985高校、研究所能够网罗大批人才。如果不能面对面,那就通过学术论文、会议、博客等等。总之,一定要让自己的眼界开拓,不能只局限在自己的实验室、自己的学校。积极主动的通过各种途径去接触前沿,免得自己毕业之时变成井底之蛙,OK,题外话到此为止。

二、DeepLearning与类脑结构

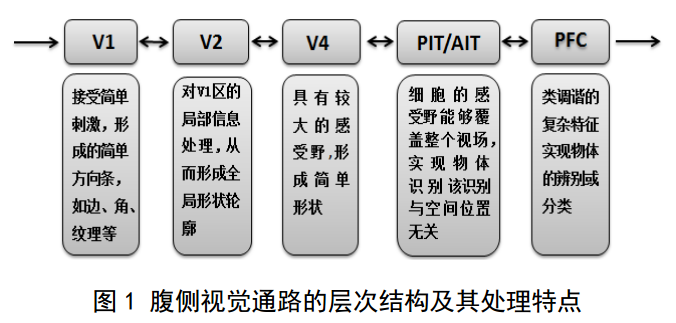

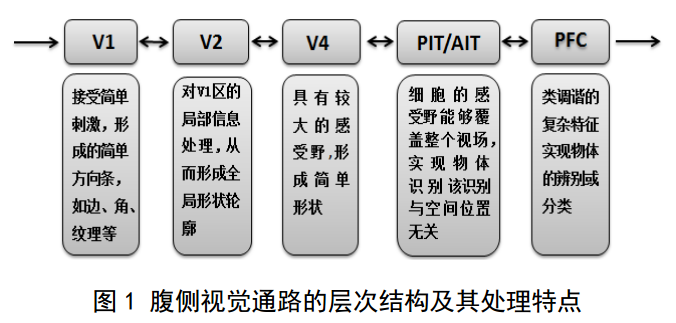

研究过深度学习的人都会思考这样两个问题:一是DeepLearning为什么威力如此强大,二是如何让深度学习训练起来更快,也就是神经网络的加速问题。深度学习之所以威力强大,一个很重要的原因就是它是一种“类脑”结构。在焦李成教授所写的《稀疏认知学习、计算与识别的研究进展》一文中,曾详细的介绍了人脑在视觉处理方面的分层结构:

所以说也正是人脑这种天然的深层结构为DeepLearning提取到的深度特征的有效性提供了强力支持。因此可以说DeepLearning能够成功主要有三个原因:(1)仿生学的支持。说白了就是DeepLearning符合大脑的深层结构,81年代即证实,存在即合理。(2)算法上的突破。2006年大牛Hinton提出两个观点:多隐层神经网络具有优异的学习能力,学习到的特征能对数据进行跟本质的表示,有利益模式分类;深度神经网络在训练上的难度,可通过“逐层初始化”来有效克服。(3)大数据的市场。深度学习需要海量数据,而如今大数据的时代到来。

DeepLearning的辉煌成就给大家敲了一个惊世警钟(这个形容词可能不太合理),就是人脑的潜力是无穷无尽的,DeepLearning可以说就是人脑给人类回馈的一个大礼,这也引发了人们对大脑结构的逆向反思。组成大脑学习与记忆的模块结构包括组织信息预处理和识别的大脑皮层以及记忆的海马体。

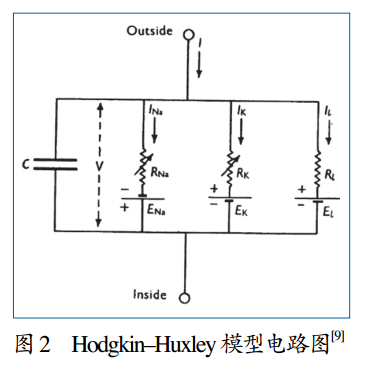

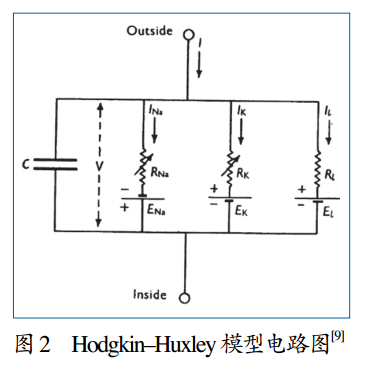

研究大脑结构必然要从最基本的神经元研究开始,人们通过对线虫(一种非常基本的多细胞生物)的研究,已经基本弄清神经元的工作原理:神经递质的释放会导致一个对动作电位到来的响应。当神经元接受到其中一个神经递质信号后,便不再继续发射动作电位,二是建立一个阈值。之后当它们接受到一定数量的信号,直至超过阈值之后,它们才能再发射一个动作电位,并重置自身。神经元的这一动作特性可以通过电容和电阻组合进行较好的模拟:

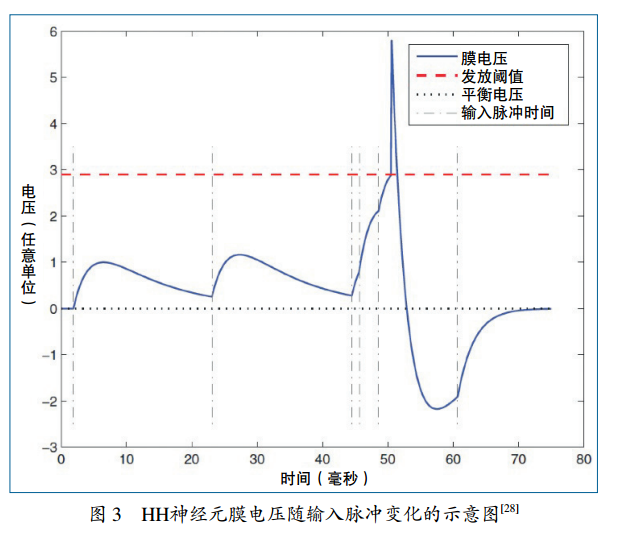

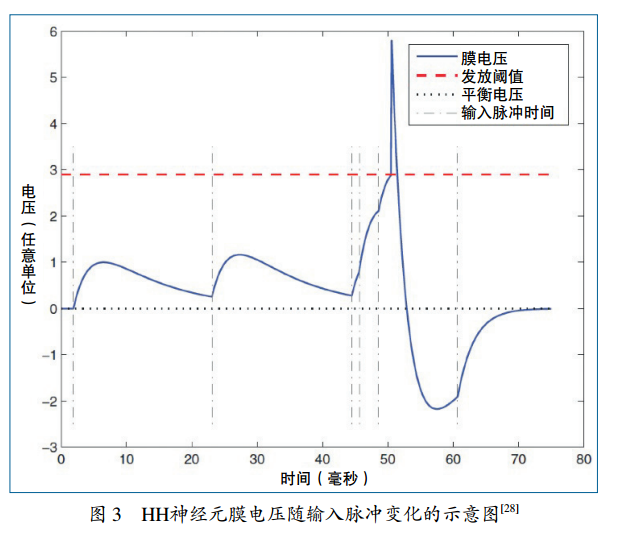

所模拟的电压响应示意图如下:

在文章《神经拟态的类脑计算研究》有对HH模型的详细描述。文中还介绍了一种应用更为广泛的LIF电流模型,这里不再赘述。

三、类脑神经网络加速器

在对神经元有了较为充分的认识之后,人们便开始着手搭建类脑计算结构,尤其是越来越多的学者都认为基于冯诺依曼体系结构的计算机已经趋于极限,难以突破量子壁垒,回归仿生学,开发生物计算机才是今后的发展之道。于是出现了各种各样的神经网络加速器。

在深度学习领域一直有一个大家争论不休的问题,就是采用何种加速器。深度学习计算量巨大,必须要进行加速处理才能满足需求,现有的加速方案有三种:(1)通过图形处理器进行加速,也就是GPU。(2)通过专用的神经网络计算芯片进行加速。(3)通过大规模运算核集联。理论上来说后两种方法在本质上是相同的。GPU在速度提升方面略低于神经网络芯片,但其通用性好,换句话说就是一片GPU通过编程可以加速各种各样的神经网络算法;相反,神经网络芯片的加速效果更好,往往能达到同品级GPU的1.5倍左右,但是其通用性较差,也就是一款神经网络芯片只能加速一种或几种神经网络算法,若算法发生改变,相应的也要更换加速芯片。举个例子,在《机器学习加速器》一文中所提到的PuDianNao加速器能够加速若干机器学习算法,加速效果是NVIDIA

K20 GPU的1.2倍。所以说将来的机器学习算法加速到底会选用何种方法,目前尚不明朗,GPU和神经网络芯片也是各有千秋。

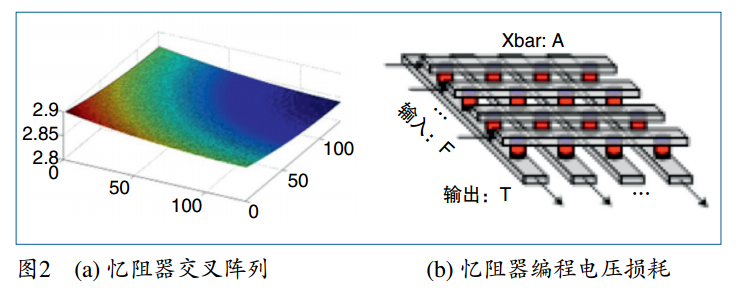

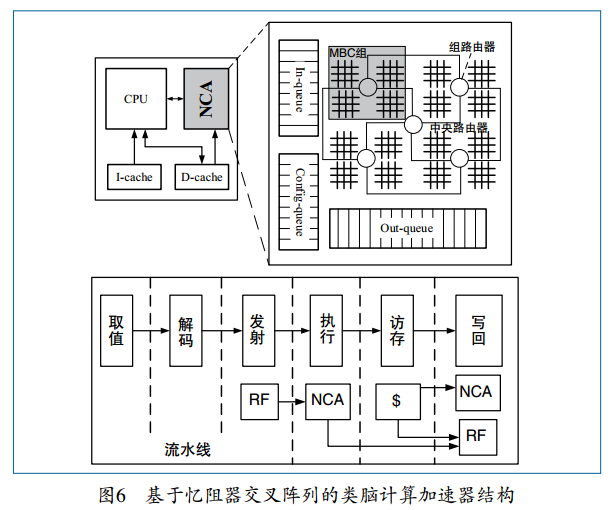

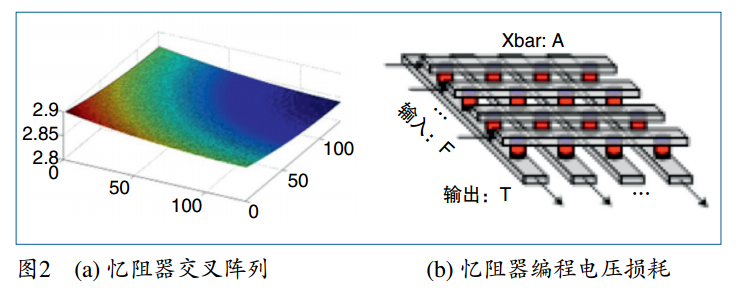

说到神经网络加速器,2007年纳米尺寸忆阻器的发明方面算是这方面的一个里程碑式的突破。通过调节施加在其上的电流或者电压脉冲的长度或者幅度,就可以改变忆阻器的阻值,这无疑给我们提供了另外一种可编程逻辑器件的构造思路——基于忆阻器交叉阵列的突触设计:

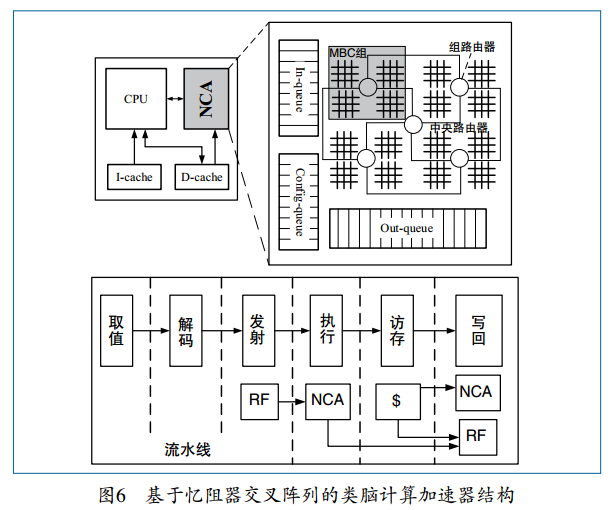

以及基于忆阻器的类脑计算加速器结构:

在《基于新型纳米器件的类脑计算系统》一文中给出了详细的关于忆阻器的相关介绍,这里不再赘述。

神经网络加速器本质上是一个超微超规模运算核的级联,在此基础上衍生出一个新的事物——神经拟态计算机:

这种计算装置就是试图通过超规模级联,最大程度还原模拟大脑结构的神经元组织方式,甚至不惜抛弃数字计算机而使用模拟机,来进行类脑计算。通过尽可能微型的结构来模拟神经元,然后尝试各种方式来实现与大脑神经元相似的连接模式,如此看来,唯一限制神经拟态计算机的类人水平的的指标就是它的规模,如果真是这样的话,在未来神经拟态计算机有望超越人类大脑的智力水平,原因很简单,人类经过几万年的进化才达到现在的脑容量,而计算机中芯片的规模只需几年就可以翻番。到那时机器人的智能水平就不仅仅局限在语音助手、聊天机器人这个层面上,可能会真如人工智能领域的创造者之一马文·明斯基所预言的:“假如规模是唯一瓶颈的话,机器人将会把人类当宠物”。

四、总结

写完这篇博文后,给我自己的启发有三个:眼界要开阔,大脑很强大,DeepLearning很火。

一、导言

首先,看完杂志之后的一个最大的感触就是“一个人的眼界很重要”。为什么这么说呢,作为一个算法研究人员,我们每天都在看论文,去搜寻别人提出的方法,从本质上讲这就是有一个扩宽眼界的过程。和牛人交流的方式多种多样,最直接有效的当然是面对面,这也是为什么那些985高校、研究所能够网罗大批人才。如果不能面对面,那就通过学术论文、会议、博客等等。总之,一定要让自己的眼界开拓,不能只局限在自己的实验室、自己的学校。积极主动的通过各种途径去接触前沿,免得自己毕业之时变成井底之蛙,OK,题外话到此为止。

二、DeepLearning与类脑结构

研究过深度学习的人都会思考这样两个问题:一是DeepLearning为什么威力如此强大,二是如何让深度学习训练起来更快,也就是神经网络的加速问题。深度学习之所以威力强大,一个很重要的原因就是它是一种“类脑”结构。在焦李成教授所写的《稀疏认知学习、计算与识别的研究进展》一文中,曾详细的介绍了人脑在视觉处理方面的分层结构:

所以说也正是人脑这种天然的深层结构为DeepLearning提取到的深度特征的有效性提供了强力支持。因此可以说DeepLearning能够成功主要有三个原因:(1)仿生学的支持。说白了就是DeepLearning符合大脑的深层结构,81年代即证实,存在即合理。(2)算法上的突破。2006年大牛Hinton提出两个观点:多隐层神经网络具有优异的学习能力,学习到的特征能对数据进行跟本质的表示,有利益模式分类;深度神经网络在训练上的难度,可通过“逐层初始化”来有效克服。(3)大数据的市场。深度学习需要海量数据,而如今大数据的时代到来。

DeepLearning的辉煌成就给大家敲了一个惊世警钟(这个形容词可能不太合理),就是人脑的潜力是无穷无尽的,DeepLearning可以说就是人脑给人类回馈的一个大礼,这也引发了人们对大脑结构的逆向反思。组成大脑学习与记忆的模块结构包括组织信息预处理和识别的大脑皮层以及记忆的海马体。

研究大脑结构必然要从最基本的神经元研究开始,人们通过对线虫(一种非常基本的多细胞生物)的研究,已经基本弄清神经元的工作原理:神经递质的释放会导致一个对动作电位到来的响应。当神经元接受到其中一个神经递质信号后,便不再继续发射动作电位,二是建立一个阈值。之后当它们接受到一定数量的信号,直至超过阈值之后,它们才能再发射一个动作电位,并重置自身。神经元的这一动作特性可以通过电容和电阻组合进行较好的模拟:

所模拟的电压响应示意图如下:

在文章《神经拟态的类脑计算研究》有对HH模型的详细描述。文中还介绍了一种应用更为广泛的LIF电流模型,这里不再赘述。

三、类脑神经网络加速器

在对神经元有了较为充分的认识之后,人们便开始着手搭建类脑计算结构,尤其是越来越多的学者都认为基于冯诺依曼体系结构的计算机已经趋于极限,难以突破量子壁垒,回归仿生学,开发生物计算机才是今后的发展之道。于是出现了各种各样的神经网络加速器。

在深度学习领域一直有一个大家争论不休的问题,就是采用何种加速器。深度学习计算量巨大,必须要进行加速处理才能满足需求,现有的加速方案有三种:(1)通过图形处理器进行加速,也就是GPU。(2)通过专用的神经网络计算芯片进行加速。(3)通过大规模运算核集联。理论上来说后两种方法在本质上是相同的。GPU在速度提升方面略低于神经网络芯片,但其通用性好,换句话说就是一片GPU通过编程可以加速各种各样的神经网络算法;相反,神经网络芯片的加速效果更好,往往能达到同品级GPU的1.5倍左右,但是其通用性较差,也就是一款神经网络芯片只能加速一种或几种神经网络算法,若算法发生改变,相应的也要更换加速芯片。举个例子,在《机器学习加速器》一文中所提到的PuDianNao加速器能够加速若干机器学习算法,加速效果是NVIDIA

K20 GPU的1.2倍。所以说将来的机器学习算法加速到底会选用何种方法,目前尚不明朗,GPU和神经网络芯片也是各有千秋。

说到神经网络加速器,2007年纳米尺寸忆阻器的发明方面算是这方面的一个里程碑式的突破。通过调节施加在其上的电流或者电压脉冲的长度或者幅度,就可以改变忆阻器的阻值,这无疑给我们提供了另外一种可编程逻辑器件的构造思路——基于忆阻器交叉阵列的突触设计:

以及基于忆阻器的类脑计算加速器结构:

在《基于新型纳米器件的类脑计算系统》一文中给出了详细的关于忆阻器的相关介绍,这里不再赘述。

神经网络加速器本质上是一个超微超规模运算核的级联,在此基础上衍生出一个新的事物——神经拟态计算机:

这种计算装置就是试图通过超规模级联,最大程度还原模拟大脑结构的神经元组织方式,甚至不惜抛弃数字计算机而使用模拟机,来进行类脑计算。通过尽可能微型的结构来模拟神经元,然后尝试各种方式来实现与大脑神经元相似的连接模式,如此看来,唯一限制神经拟态计算机的类人水平的的指标就是它的规模,如果真是这样的话,在未来神经拟态计算机有望超越人类大脑的智力水平,原因很简单,人类经过几万年的进化才达到现在的脑容量,而计算机中芯片的规模只需几年就可以翻番。到那时机器人的智能水平就不仅仅局限在语音助手、聊天机器人这个层面上,可能会真如人工智能领域的创造者之一马文·明斯基所预言的:“假如规模是唯一瓶颈的话,机器人将会把人类当宠物”。

四、总结

写完这篇博文后,给我自己的启发有三个:眼界要开阔,大脑很强大,DeepLearning很火。

相关文章推荐

- 对于System.Net.Http的学习(一)——System.Net.Http 简介(转)

- 猿题库 iOS 客户端架构设计(原文地址:http://gracelancy.com/blog/2016/01/06/ape-ios-arch-design/)

- Java学习之网络编程实例

- pyhton对网络设备的日常巡检

- pyhton对网络设备的日常巡检

- UNIX网络编程——select函数的并发限制和 poll 函数应用举例

- android httpClient 支持HTTPS的2种处理方式

- HTTP 错误 404.2 - Not Found。由于 Web 服务器上的“ISAPI 和 CGI 限制”列表设置,无法提供您请求的页面

- 《数学之美》马尔科夫链的扩展-贝叶斯网络

- TCP Socket和ZeroMQ socket的区别

- 贝叶斯信念网络和马尔科夫链有什么区别

- 【转】贝叶斯网络+马尔科夫毯 简介

- codevs1907 方格取数 3||tyvj1338QQ农场|网络流

- 如何使用http或httpClient向服务器上传图片 以及使用http上传图片时协议的描述

- https GET请求

- android的网络通信

- 从僵尸网络追踪到入侵检测 第3章 Honeyd服务(23端口防御)

- bzoj3931【CQOI2015】网络吞吐量

- Self Organizing Maps (SOM): 一种基于神经网络的聚类算法

- 扯谈网络编程之自己实现ping