Spark入门到精通视频学习资料--第二章:Spark生态系统介绍,Spark整体概述与Spark编程模型(2讲)

2015-02-26 13:58

691 查看

概述

什么是Spark

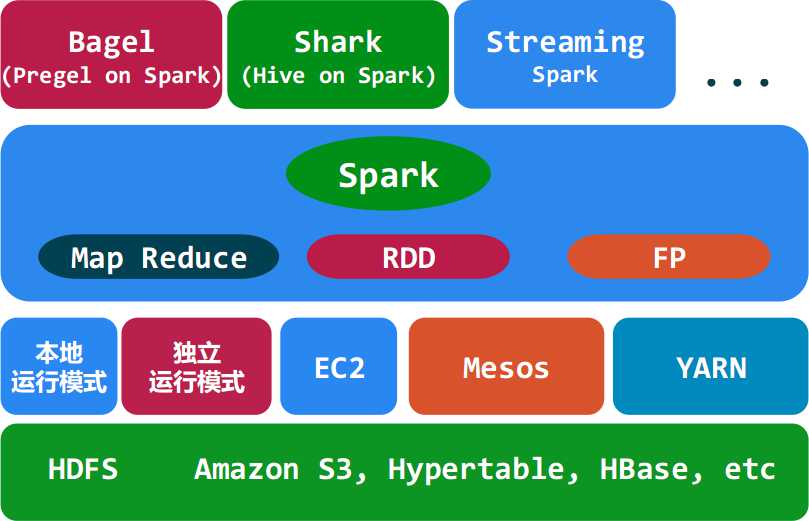

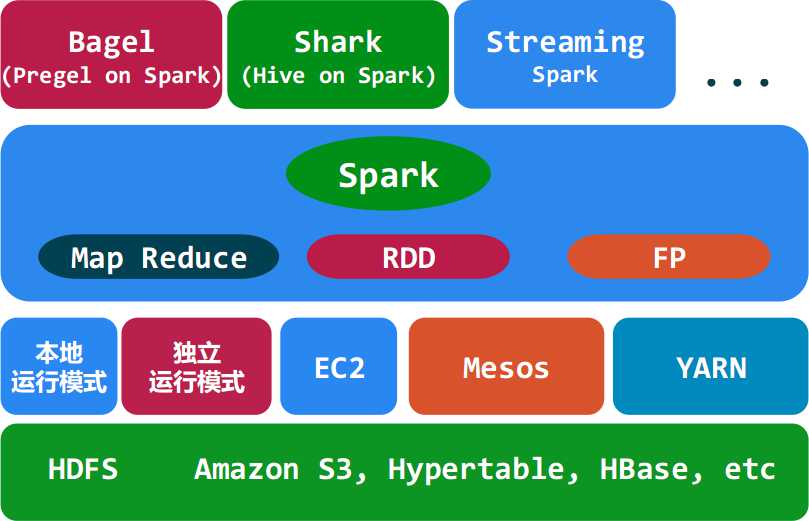

◆ Spark是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于map reduce算法实现的分布式计算,拥有Hadoop MapReduce所具有的优点;但不同于MapReduce的是Job中间输出和结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的map reduce的算法。其架构如下图所示:

Spark的适用场景

◆ Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。需要反复操作的次数越多,所需读取的数据量越大,受益越大,数据量小但是计算密集度较大的场合,受益就相对较小

◆ 由于RDD的特性,Spark不适用那种异步细粒度更新状态的应用,例如web服务的存储或者是增量的web爬虫和索引。就是对于那种增量修改的应用模型不适合。

◆ 总的来说Spark的适用面比较广泛且比较通用。

详细内容请参考视频:

Spark概述与编程模型(上) http://pan.baidu.com/s/1kT9okBl Spark概述与编程模型(下) http://pan.baidu.com/s/16OEjc

另外给个相关的PDF文件供参考:

Spark概述与编程模型.pdf http://pan.baidu.com/s/1mg64rMw

==========================================================

申明:视频资料已过期,建议不要再下载了。

==========================================================

什么是Spark

◆ Spark是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于map reduce算法实现的分布式计算,拥有Hadoop MapReduce所具有的优点;但不同于MapReduce的是Job中间输出和结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的map reduce的算法。其架构如下图所示:

Spark的适用场景

◆ Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。需要反复操作的次数越多,所需读取的数据量越大,受益越大,数据量小但是计算密集度较大的场合,受益就相对较小

◆ 由于RDD的特性,Spark不适用那种异步细粒度更新状态的应用,例如web服务的存储或者是增量的web爬虫和索引。就是对于那种增量修改的应用模型不适合。

◆ 总的来说Spark的适用面比较广泛且比较通用。

详细内容请参考视频:

Spark概述与编程模型(上) http://pan.baidu.com/s/1kT9okBl Spark概述与编程模型(下) http://pan.baidu.com/s/16OEjc

另外给个相关的PDF文件供参考:

Spark概述与编程模型.pdf http://pan.baidu.com/s/1mg64rMw

==========================================================

申明:视频资料已过期,建议不要再下载了。

==========================================================

相关文章推荐

- Spark入门到精通视频学习资料--第五章:Shark介绍与使用(2讲)

- Spark入门到精通视频学习资料--第七章:Spark多语言编程(1讲)

- Spark入门到精通视频学习资料--第一章、Scala基础与实践

- Spark入门到精通视频学习资料--第三章:Spark进阶(2讲)

- Spark入门到精通视频学习资料--第四章:基于Spark的流处理框架Spark Streaming(2讲)

- Spark入门到精通视频学习资料--第六章:Machine Learning on Spark(1讲)

- Spark入门到精通视频学习资料--第八章:项目实战(2讲)

- Spark修炼之道(进阶篇)——Spark入门到精通:第四节 Spark编程模型(一)

- Spark修炼之道(进阶篇)——Spark入门到精通:第五节 Spark编程模型(二)

- 韩顺平_php从入门到精通_视频教程_第13讲_选择器使用细节_块元素和行内元素_盒子模型_盒子模型经典应用①_学习笔记_源代码图解_PPT文档整理

- 韩顺平_php从入门到精通_视频教程_第14讲_盒子模型经典应用②_作业布置_学习笔记_源代码图解_PPT文档整理

- Spark修炼之道(进阶篇)——Spark入门到精通:第六节 Spark编程模型(三)

- Spark修炼之道(进阶篇)——Spark入门到精通:第四节 Spark编程模型(一)

- Spark修炼之道(进阶篇)——Spark入门到精通:第五节 Spark编程模型(二)

- Spark修炼之道(进阶篇)——Spark入门到精通:第六节 Spark编程模型(三)

- 韩顺平_php从入门到精通_视频教程_第1讲_html介绍_html运行原理①_学习笔记_源代码图解_PPT文档整理

- 韩顺平_php从入门到精通_视频教程_第0讲_开山篇_学习笔记_源代码图解_PPT文档整理

- 黄聪:Python语言编程学习资料(电子书+视频教程)下载汇总

- Java学习从入门到精通的简单介绍

- 韩顺平_php从入门到精通_视频教程_第18讲_浮动_学习笔记_源代码图解_PPT文档整理