Windows下Cygwin环境的Hadoop安装(3)- 运行hadoop中的wordcount实例遇到的问题和解决方法

2012-07-01 23:30

1016 查看

在前面的步骤中,我们已经建立了hadoop环境,下面该运行一个实例了,就拿hadoop自带的wordcount练手吧。

- 建立本地数据文件

在我们准备的hadoop本地文件夹data下建立一个data_in文件夹,并在此文件夹下创建两个数据文件,分别是file1.txt和file2.txt。

file1.txt中保存一个句子:Hello world!

file2.txt中保存一个句子:I am the king of the world!

- 上传数据文件至dfs文件系统

下面我们要将本地建立的两个数据文件上传到hdfs文件系统中。

(以下过程,如果没有启动hadoop环境,请参考hadoop安装过程中启动hadoop的方法先启动hadoop环境,否则会看到“Retrying connect to server”的错误)

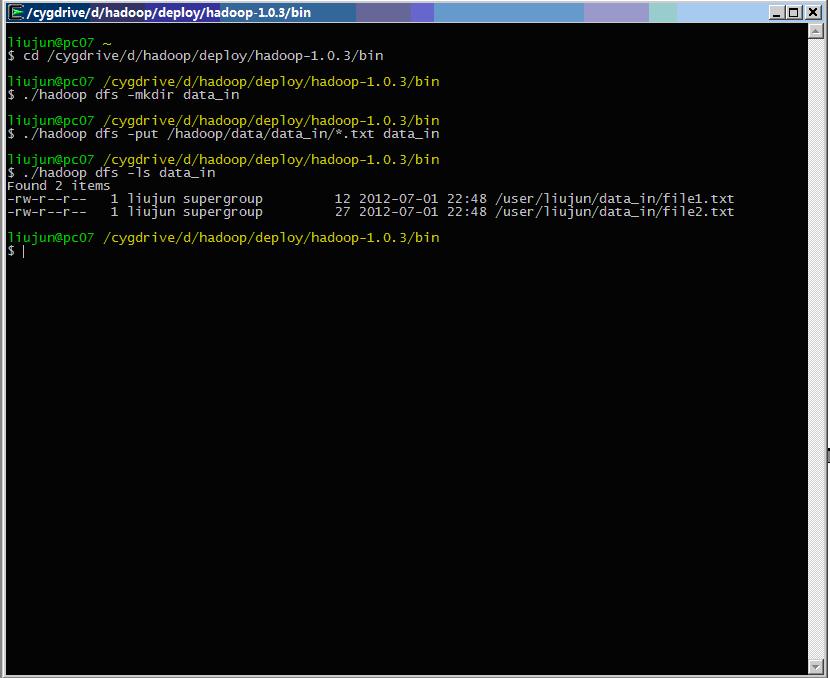

* 进入cygwin环境

* 进入hadoop的bin目录:cd /cygdrive/d/hadoop/deploy/hadoop-1.0.3/bin

* 在hdfs上建立data_in目录:./hadoop dfs -mkdir data_in

* 上传数据文件:./hadoop dfs -put /hadoop/data/data_in/*.txtdata_in

* 查看文件上传成功:./hadoop dfs -ls data_in

整个过程如下图所示:

- 执行wordcount程序

数据文件准备好了,我们就可以执行wordcount程序了。

在hadoop的bin目录下执行:

./hadoop jar ./../hadoop-examples-1.0.3.jarwordcount data_in data_out

在运行wordcount程序中,我曾经遇到过以下一些问题:

- dfs上传文件,报“Permission denied”错误

解决方法:设置hdfs-site.xml配置文件中的权限检查为false

<property>

<name>dfs.permissions</name>

<value>false</value>

<description>

If "true", enable permission checking in HDFS.

If "false", permission checking is turned off,

but all other behavior is unchanged.

Switching from one parameter value to the other does not change themode,

owner or group of files or directories.

</description>

</property>

- 执行程序遇到“Failed to set permissions of path”错误

这个错误可能出现在若干地方,例如taskTracker不启动、运行wordcount程序直接报此错误等。通常看到的错误都是不能将某个文件或目录设置为权限0700或0755等。

这个问题有很多人遇到过,是某些hadoop版本中存在的bug,在windows系统中不能兼容文件权限操作。至于解决方法,有说将cygwin的bin目录添加到windows系统的PATH路径中,有说将hadoop系统代码中的0700修改为0777等,但我都试过,都不管用,最终解决方法,是修改hadoop的FileUtil类下如下代码:

private

static void checkReturnValue(boolean rv, File p,

FsPermission permission

) throws IOException {

// if (!rv) {

// throw new IOException("Failed to setpermissions of path: " + p +

// " to " +

// String.format("%04o", permission.toShort()));

// }

}

即将文件权限检查的代码注释掉,可以规避掉此错误。

修改hadoop系统文件并便宜发布的方法,请参考《Windows下Cygwin环境的Hadoop安装(4)- 在Eclipse中建立hadoop开发环境》(/article/8054665.html)。

- 执行wordcount时不能创建临时文件的错误

在执行时,可能看到这样的错误:Cannot create directory /user/root/output2/_temporary

解决方法是:在主节点处,关闭掉安全模式,即执行以下指令:

./hadoop dfsadmin –safemode leave

点击这里查看全过程索引

- 建立本地数据文件

在我们准备的hadoop本地文件夹data下建立一个data_in文件夹,并在此文件夹下创建两个数据文件,分别是file1.txt和file2.txt。

file1.txt中保存一个句子:Hello world!

file2.txt中保存一个句子:I am the king of the world!

- 上传数据文件至dfs文件系统

下面我们要将本地建立的两个数据文件上传到hdfs文件系统中。

(以下过程,如果没有启动hadoop环境,请参考hadoop安装过程中启动hadoop的方法先启动hadoop环境,否则会看到“Retrying connect to server”的错误)

* 进入cygwin环境

* 进入hadoop的bin目录:cd /cygdrive/d/hadoop/deploy/hadoop-1.0.3/bin

* 在hdfs上建立data_in目录:./hadoop dfs -mkdir data_in

* 上传数据文件:./hadoop dfs -put /hadoop/data/data_in/*.txtdata_in

* 查看文件上传成功:./hadoop dfs -ls data_in

整个过程如下图所示:

- 执行wordcount程序

数据文件准备好了,我们就可以执行wordcount程序了。

在hadoop的bin目录下执行:

./hadoop jar ./../hadoop-examples-1.0.3.jarwordcount data_in data_out

在运行wordcount程序中,我曾经遇到过以下一些问题:

- dfs上传文件,报“Permission denied”错误

解决方法:设置hdfs-site.xml配置文件中的权限检查为false

<property>

<name>dfs.permissions</name>

<value>false</value>

<description>

If "true", enable permission checking in HDFS.

If "false", permission checking is turned off,

but all other behavior is unchanged.

Switching from one parameter value to the other does not change themode,

owner or group of files or directories.

</description>

</property>

- 执行程序遇到“Failed to set permissions of path”错误

这个错误可能出现在若干地方,例如taskTracker不启动、运行wordcount程序直接报此错误等。通常看到的错误都是不能将某个文件或目录设置为权限0700或0755等。

这个问题有很多人遇到过,是某些hadoop版本中存在的bug,在windows系统中不能兼容文件权限操作。至于解决方法,有说将cygwin的bin目录添加到windows系统的PATH路径中,有说将hadoop系统代码中的0700修改为0777等,但我都试过,都不管用,最终解决方法,是修改hadoop的FileUtil类下如下代码:

private

static void checkReturnValue(boolean rv, File p,

FsPermission permission

) throws IOException {

// if (!rv) {

// throw new IOException("Failed to setpermissions of path: " + p +

// " to " +

// String.format("%04o", permission.toShort()));

// }

}

即将文件权限检查的代码注释掉,可以规避掉此错误。

修改hadoop系统文件并便宜发布的方法,请参考《Windows下Cygwin环境的Hadoop安装(4)- 在Eclipse中建立hadoop开发环境》(/article/8054665.html)。

- 执行wordcount时不能创建临时文件的错误

在执行时,可能看到这样的错误:Cannot create directory /user/root/output2/_temporary

解决方法是:在主节点处,关闭掉安全模式,即执行以下指令:

./hadoop dfsadmin –safemode leave

点击这里查看全过程索引

相关文章推荐

- Windows下Cygwin环境的Hadoop安装(3)- 运行hadoop中的wordcount实例遇到的问题和解决方法

- Windows下Cygwin环境的Hadoop安装(3)- 运行hadoop中的wordcount实例遇到的问题和解决方法

- 在windows上用eclipse远程运行hadoop上的wordcount程序出现的问题,求解决

- windows环境下跑hadoop自带的wordcount遇到的问题

- hadoop2.7.3 Windows eclipse开发环境搭建及WordCount实例运行

- hadoop2.2.0配置eclipse运行wordcount程序问题及解决方法

- windows 环境下部署spark运行环境 (包含遇到的问题和解决方法)

- Hadoop MapReduce案例word count本地环境运行时遇到的一些问题

- Windows下安装MySQLdb遇到的问题及解决方法

- Ubuntu14.04安装配置Hadoop2.6.0(完全分布式)与 wordcount实例运行

- windows环境下python安装pycrypto遇到的问题解决

- Hadoop在Linux下伪分布式的安装以及wordcount实例的运行还有Eclipse的使用

- win7(64位)平台下Cygwin+Eclipse搭建Hadoop单机开发环境 (四) 导入Hadoop源码+wordcount程序+运行

- 安装PHP运行环境时候vcruntime140.dll问题的解决方法

- cygwin+hadoop+eclipse (三) 运行wordcount实例

- VM 安装Linux虚拟服务器:环境搭建遇到:《Linux “ifconfig”看不到inet address》问题--解决土方法

- Hadoop在Linux下伪分布式的安装 以及wordcount实例的运行

- Windows下使用Composer安装yii2遇到的问题及解决方法

- windows平台使用Cygwin安装hadoop遇到的问题

- Ubuntu14.04安装配置Hadoop2.6.0(完全分布式)与 wordcount实例运行